hive执行作业时reduce任务个数设

reducer个数的设定➳极大影响执行效率❀

1. hive.exec.reducers.bytes.per.reducer(默认为1000^3)

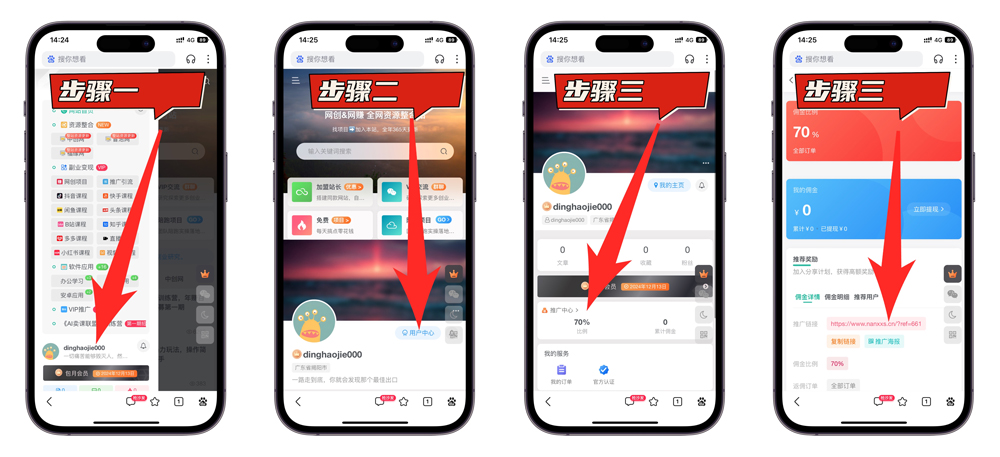

2. hive.exec.reducers.max(默认为999) 计算reducer数♙的公式很简单: N=min(参数2,总输入数据量/参数1) 通常情况下,有必要手动指定reducer个数。考虑到map阶段的输出数据量通常会比输入有大幅减少,因❤此即使不设定reducer个数,重设参数2还是必要♝的。依据Hadoop的经验,可以将参数2设定为0.95(集群中TaskTracker个数)。![图片[1]-hive执行作业时☢reduce任务个数设-酷知号](https://i0.hdslb.com/bfs/article/e55de3a1213320d368622f31d040c14932459a0c.jpg@1026w_744h.webp) 正确的reduce任务的 个数应该是 0.95或者1.75 ×(节点数 ×mapred.tasktracker.tasks.maximum参数值)

正确的reduce任务的 个数应该是 0.95或者1.75 ×(节点数 ×mapred.tasktracker.tasks.maximum参数值)

![图片[2]-hive执行作业时☢reduce任务个数设-酷知号](https://www.lbseo.cn/wp-content/uploads/2024/12/ka3kcsd0fg.png)

© 版权声明

1、本内容转载于网络,版权归原作者所有!

2、本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。

3、本内容若侵犯到你的版权利益,请联系我们,会尽快给予删除处理!

4、本站全资源仅供测试和学习,请勿用于非法操作,一切后果与本站无关。

5、如遇到充值付费环节课程或软件 请马上删除退出 涉及自身权益/利益 需要投资的一律不要相信,访客发现请向客服举报。

6、本教程仅供揭秘 请勿用于非法违规操作 否则和作者 官网 无关

THE END